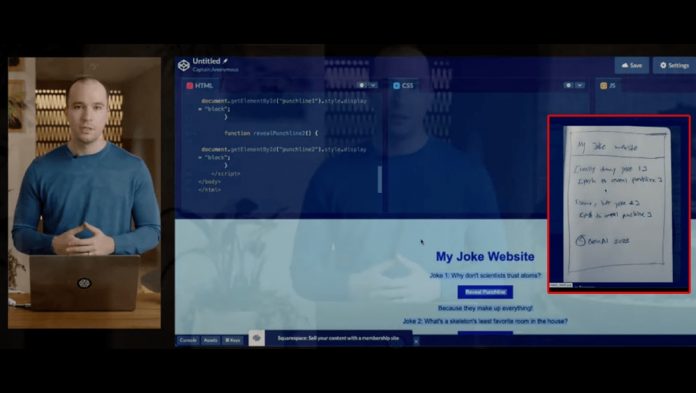

以开发出聊天机械人ChatGPT闻名的OpenAI,周二发布名为GPT-4的最新人工智能 (AI) 模型,除了准确度、创造力和协作性更高之外,GPT-4还可支援图片输入功能,并以文字来解释图像内容,甚至回答问题;甚至输入一张手绘设计草图就能自动产生对应的网页程式码。

报道指,现时的ChatGPT属于GPT-3.5版本,其于文字及图片上的表现已相当出色,吸引众多科企将旗下产品加入该技术。而GPT-4是一个多模态的AI模型,除了文字输入以外,还可透过图像输入来生成内容。

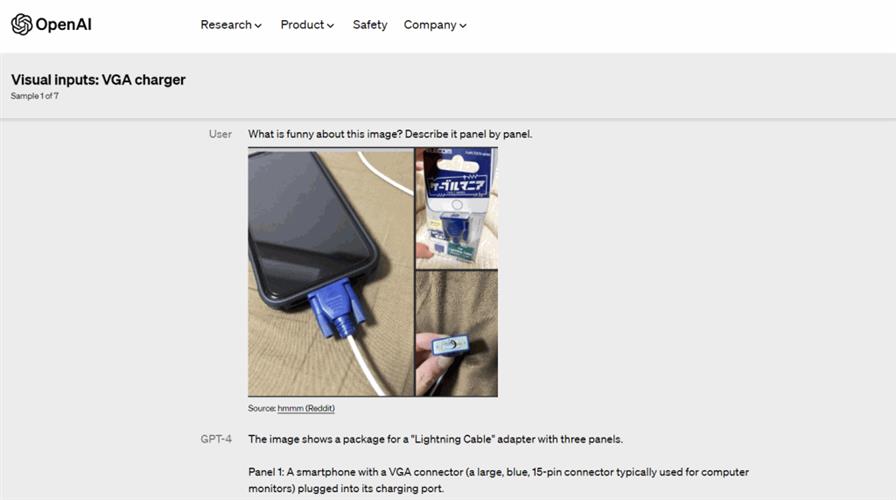

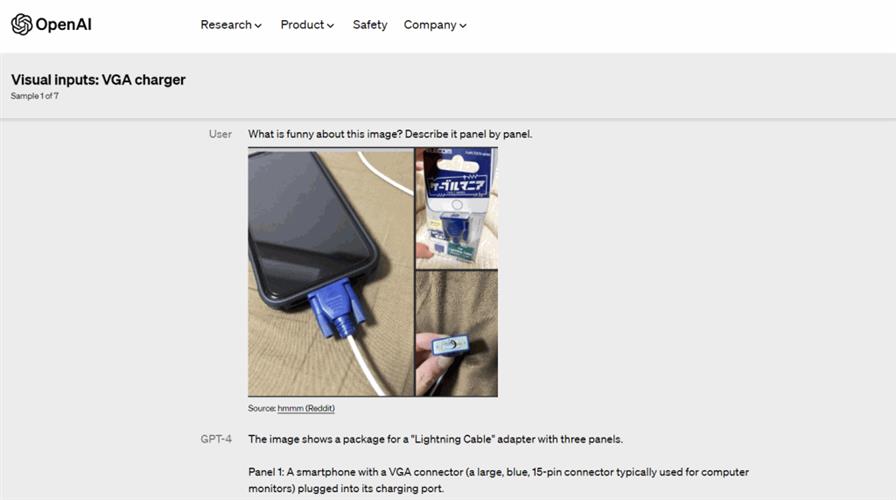

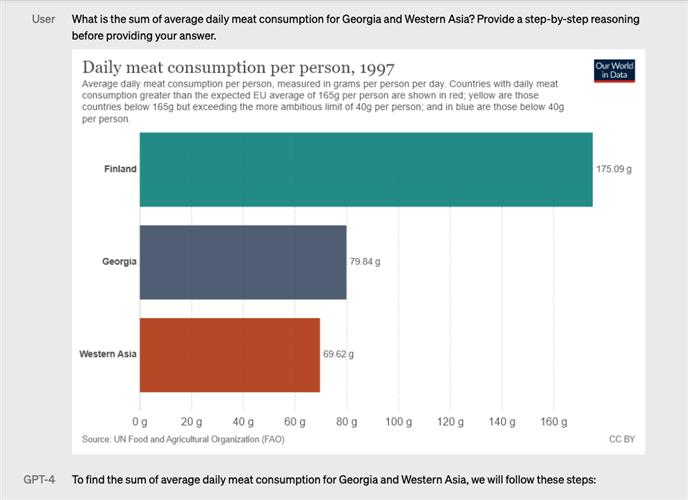

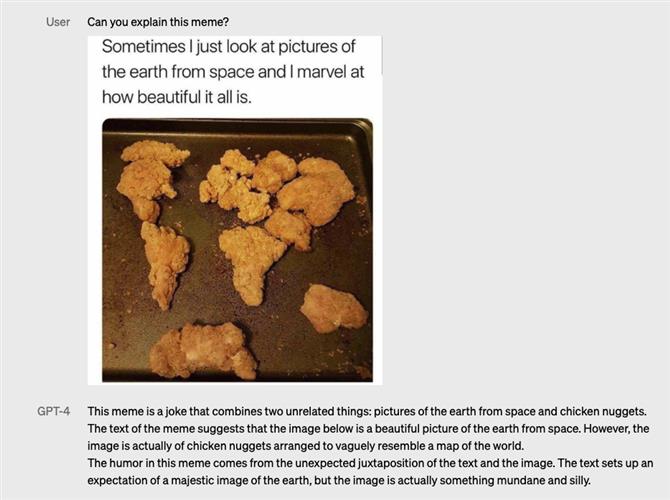

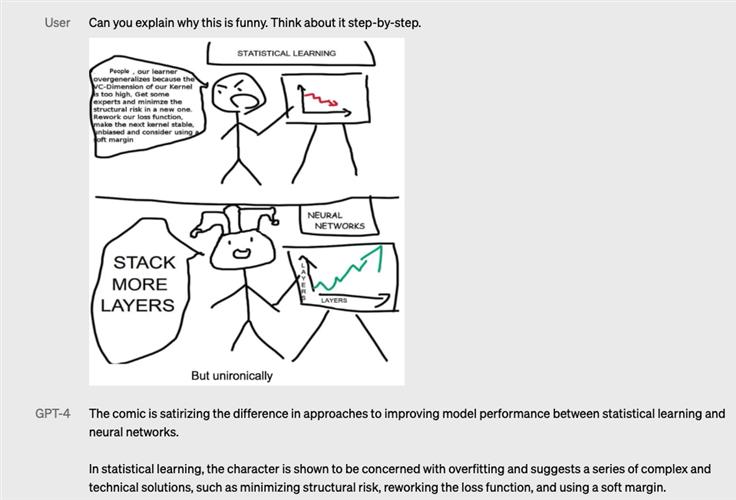

GPT-4会以文字来解释图片内容,并且符合文字任务的要求。输入的图片可以是照片、图表或萤幕截图。举例来说,如果用家发送雪柜内部的图片,GPT-4不仅能正确识别有甚么,还会调制可以用这些材料制成的东西。

未来,GPT-4还将持续强化解图能力,例如可以输入多组图片范例,或是提供分解动作解释的解图能力。

OpenAI透过网志表示,使用微软的Azure训练GPT-4模型,相较于前一版的GPT-3.5,GPT-4有了巨幅改进,又指新模型将产生更少的错误答案、减少偏离轨道和谈论禁忌话题的频率。

较早前,在与ChatGPT或Bing的的互动中,传出许多用家被呈现谎言、侮辱或其他所谓的“幻觉”。OpenAI表示:“我们花了6个月的时间使GPT-4更安全、更一致。GPT-4回应不允许内容请求降低了82%,产生事实回应的可能性增加了40%”。

在模拟美国法学院毕业生参加律师考试的实测中,GPT-4的分数可达到前10%左右,GPT-3.5却只能落在最底的10%。在SAT数学测验或GRE测验等30多项不同学科的主流检定测验上,GPT-4都大胜3.5版。

OpenAI宣称,GPT-4英文答题的正确率达到80.5%,高于3.5版的70.1%,甚至也高于Google日前的PaLM模型英文答题的69.3%正确率。不过,PaLM答题正确率是OpenAI自行实测的结果,而非Google官方数据。值得注意的是,GPT-4对翻译成中文版的MMLU答题正确率也达到了80.1%,日语和韩语版也都有70至80%的正确率。

OpenAI说,虽然在一般对话中,GPT-3.5和GPT-4两种版本模型的生成内容相当类似,但是当任务的复杂度达到一定门槛时,差异就会浮现,GPT-4更有能力处理更细腻的指令。

根据OpenAI,摩根士丹利正在使用 GPT-4 来整理数据,电子支付商Stripe也在测试是否可利用GPT-4来杜绝诈骗,其他客户还包含线上语言学习 App“Duolingo”、线上学习平台可汗学院 (Khan Academy) 以及冰岛政府。

GPT-4目前先开放了文字输入功能予ChatGPT Plus付费用户,特定合作伙伴可优先排入试用新版。至于图片输入功能目前仍在预览阶段。